| 莊舒歆/東海大學資訊管理學系 |

人工智慧的定義

「智慧」(Intelligence)一直沒有固定的標準和定義,各領域學者對於人工智慧(Artificial Intelligence,AI)的定義也有不同的見解,以下將從哲學與電腦科學觀點來粗淺地討論不同方面的定義。

一些哲學家認為物體含有意識和精神才能稱為智慧,現階段的AI並沒有心智可言,所以他們不認同「人工智慧」這個名稱,機器是否能思考的議題,哲學家分為二元論和唯物主義,前者認為智慧是要先擁有心靈,心靈是非物理物質;因此不能以純物理來解釋,後者認為頭腦可以用物理解釋,而動腦是包含智慧的行為;所以人工智慧是合理的產物。

電腦科學與人工智慧之父Alan Turing提出:「若有一台機器能夠與人對話而不被辨識出是機器的話,這台機器就有智慧。」這就是圖靈測試[1](Turing Test),到了現今還沒有AI能夠完全達到標準。但隨著演算法與硬體設備的進步,AI學者Andreas Kaplan 則定義AI是「能從外部資料中學習並利用學習的知識,靈活達成特定目標和任務的能力。」[2]。

上述來看,學術界各有見解,定義會不斷地改變。不管現階段我們如何解讀AI有沒有所謂的「智慧」,應先開始細想被稱為有「智慧」的AI犯錯時,它能揹負起倫理學上的責任嗎?

AI的倫理

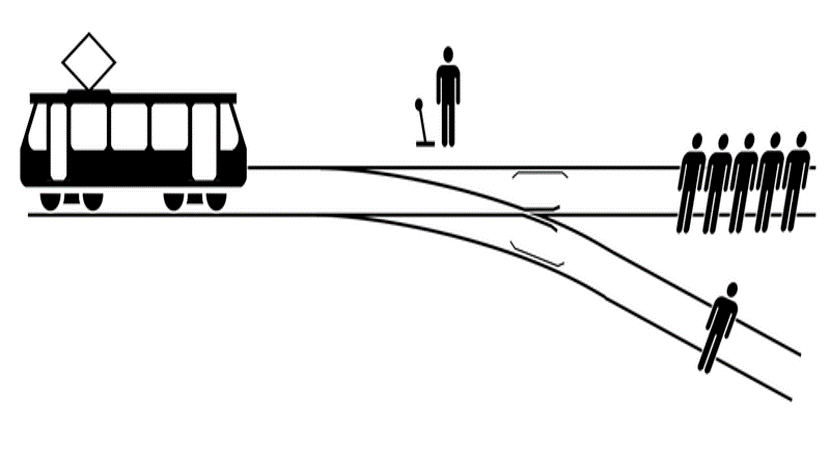

最常被討論的電車問題(Trolley problem),失控的列車在軌道上,有五個人被綁起來,另一條軌道上只有一個人被綁著,該保持原本的軌道碾壓過這五個人還是變換軌道壓另一個人?倫理學上這衍生了兩種倫理原則:

(1)效益主義:變換軌道撞上一個人而避開五個人,人會直覺認為這是追求多數人的利益。但AI思考的效益會包括許多因素,像是列車突然轉向會不會導致危險,或單獨在軌道上的那一人對社會的貢獻是否超越另五個人,AI所參考的資訊和考慮的模式與人類不同,而AI判斷價值與效益的方式,人類的觀點能接受嗎?

(2)義務倫理學:不應外在的因素改變而造成傷害,後果不是選擇的考慮因素。如果不可以殺人是一種道德義務,那就算有五個人會死亡,也不能動手讓一個人犧牲,。

AI 如何判斷應該如何做?人類在做選擇時就有不同的爭議,大多數人會選擇讓列車改道犧牲一個人,但如果那一個人是他們的親人或朋友,他們就會改變想法。除此之外還有責任的問題,當自駕車為閃避突然出現的路人而衝撞民宅,賠償責任是規於誰呢?是自駕車研發公司、車主、事發當下的乘客還是賣車的車商?這題可能是突然出現的路人要負責,但如果汽車被駭客入侵導致意外,誰要承擔?如果狀況變為閃避障礙物而造成他人傷亡,責任歸誰?

交通意外不能事先預料,訓練AI的過程中充滿人為的干預,AI 學習的是「多數人的行為模式」,但「多數人的行為模式」的數據來源是指眾人可能偏好的選擇結果,還是根據某些固定的決策模式(如義務論)決定AI要遵循的規範。杜克大學的Vincent Conitzer電腦科學教授等人提出一個想法[3],讓AI學習博奕理論並提供大量倫理及心理學文獻。他們指出信任博弈(the trust game)是倫理選擇的一個普遍特徵,除了考慮行為造成的結果,還會考慮是否有公平、不感恩、不忠誠的表現。AI能從過去選擇造成的影響來評價自己的行為,再透過學習大量文獻或許能讓AI找出最適當的倫理規則。

結語

倫理在人類判斷上就可以引發各種爭議,如果苛求AI需要搭載一個完美無缺的倫理系統讓眾人滿意是不可能的,頂多讓大多數人同意。我們說透過模擬人類心智來解決問題及決策能力的系統稱為人工智慧,重點是人類心智太過複雜,包含各種情緒、思想,有些人為大眾犧牲自己;有些人以自己利益為優先,不能說誰對誰錯,我們判斷他人的基準一向是他有無符合大眾利益,但套在自己身上時好像又是另一種標準。

或許我們該慶幸 AI回應不包含情緒與態度,雖然這就表示它回應倫理情境的表現較差(沒有同理心等),但也表示它不會以自己為中心來做判斷的基準(先假設AI不像電影演的會攻佔人類),因為餵養AI訓練數據的人類會希望它符合大眾期待。所以 AI 是否從具體情境中學習如何做正確的倫理判斷,且經過不斷的自我調整及修正達到完美,在於選擇結果能否被人類接受。

AI並不是用來取代、超越或必須比人類完美的存在,雖然道德概念充滿不確定性,但這不是反對或阻止AI發展的理由。過去石器時代以石頭作為代表性工具,青銅器時代以青銅為代表性;我們不會認為石頭、青銅要取代人類,未來人工智慧時代,也只是人類文化發展的一個階段,人們應當著重於討論相關議題,並積極思考該如何使用與活用這項「智慧」工具。

[1] A. M. Turing (1950). COMPUTING MACHINERY AND INTELLIGENCE. 檢自:https://www.csee.umbc.edu/courses/471/papers/turing.pdf

[2] Andreas Kaplana, Michael Haenlein (2018). Siri, Siri, in my hand: Who’s the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence. 檢自:https://www.sciencedirect.com/science/article/pii/S0007681318301393

[3] Vincent Conitzer, Walter Sinnott-Armstrong, Jana Schaich Borg, Yuan Deng, Max Kramer (2017). Moral Decision Making Frameworks for Artificial Intelligence. 檢自:https://users.cs.duke.edu/~conitzer/moralAAAI17.pdf